Решаем задачу о копировании файлов из каталога SRC в каталог DST, но только определенных заданных типов, сохраняя структуру каталогов.

Это может понадобиться для сбора ассетов проекта, создания архивов и т.п.

К примеру, вы хотите скопировать только видео файлы с расширениями .*avi и *.mpg. Тогда можно использовать команду rsync вот в таком виде:

|

|

rsync -am --include='*.mpg' --include='*.avi' --include='*/' --exclude='*' SRC/ DST |

Разберем, как это работает.

Флаг -m (в -am) позволяет избежать копирования пустых папок, где нет искомых файлов.

Далее идут ключи —include, которые добавляют всё новые типы файлов. Обратите внимание, что ключи чувствительны к регистру, и потому —include=’*.avi’ скопирует myfile.avi, но не myfile.AVI.

Если вам нужны любые комбинации регистра, можно воспользоваться форматом вроде:

|

|

--include='*.[aA][vV][iI]' |

Опция —include=’*/’ добавит подкаталоги, а —exclude=’*’ — исключит всё остальное.

UNIX

Данная запись опубликована в 23.02.2018 11:12 и размещена в рубрике Программирование.

Вы можете перейти в конец страницы и оставить ваш комментарий.

Мало букафф? Читайте есчо !

Ноябрь 28, 2018 г.

По умолчанию GREP выводит всю строку, где был обнаружен указанный вами шаблон поиска. Для форматированных текстовых файлов это подходит. Но если в поиск попадает минифицированный текстовый или binary файл, то в консоль вываливается неприлично много текста. ...

Читать

Январь 24, 2017 г.

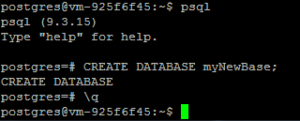

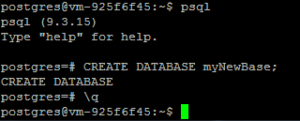

Не простая операция, если вы не имели опыта настройки / работы с postgresql до сих пор. Расскажу поэтапно как выгрузить дамп базы, и как затем этот дамп ...

Читать

Июль 24, 2017 г.

Если вы решили сэкономить и получить бесплатный SSL сертификат, то в большинстве случаев сделать это не сложно. Благодаря проекту Lets' encrypt процесс получения и настойки автоматизирован и выполняется буквально 2-3 командами в консоли сервера.

...

Читать

Январь 31, 2023 г.

... и выполнить те или иные операции в зависимости от результата проверки, используя командный процессор, например bash.

Примерно так формулируется очередная небольшая задача, возникающая в ежедневном потоке рутины автоматизации работы.

Существует ...

Читать